Resumen generado por IA

La inteligencia artificial física (Embodied AI) está transformando la sociedad al integrar máquinas autónomas en ámbitos como la industria, la salud y la movilidad. Estas máquinas no solo ejecutan órdenes, sino que toman decisiones con impacto social, lo que plantea desafíos éticos fundamentales. En el Future Trends Forum, el experto Iyad Rahwan defendió un enfoque interdisciplinario para analizar la IA física como un actor social cuyo comportamiento evoluciona en interacción con humanos y otras máquinas. Propone estudiar la IA desde una perspectiva de ciencia del comportamiento, similar a cómo se examinan humanos y animales, abordando preguntas sobre cómo aprenden normas sociales, cómo desarrollan valores y quién es responsable de sus acciones.

Rahwan utiliza el modelo de Nikolaas Tinbergen para entender la IA a través de sus mecanismos internos, desarrollo, relaciones y efectos a largo plazo. Ejemplos como la cooperación entre vehículos autónomos y humanos ilustran la necesidad de diseñar normas sociales adaptadas al contexto cultural y local, lo que complica la creación de principios éticos universales. Experimentos como la «Moral Machine» evidencian diferencias culturales en decisiones morales, subrayando la importancia de equilibrio entre valores locales y universales. Para un futuro responsable, Rahwan destaca tres pilares: transparencia, supervisión humana y educación ciudadana, insistiendo en que la IA debe ser comprendida y regulada para convivir éticamente en la sociedad.

Iyad Rahwan, director del Max Planck Institute for Human Development, analiza el comportamiento de las máquinas y los retos éticos que plantea la IA física en la sociedad

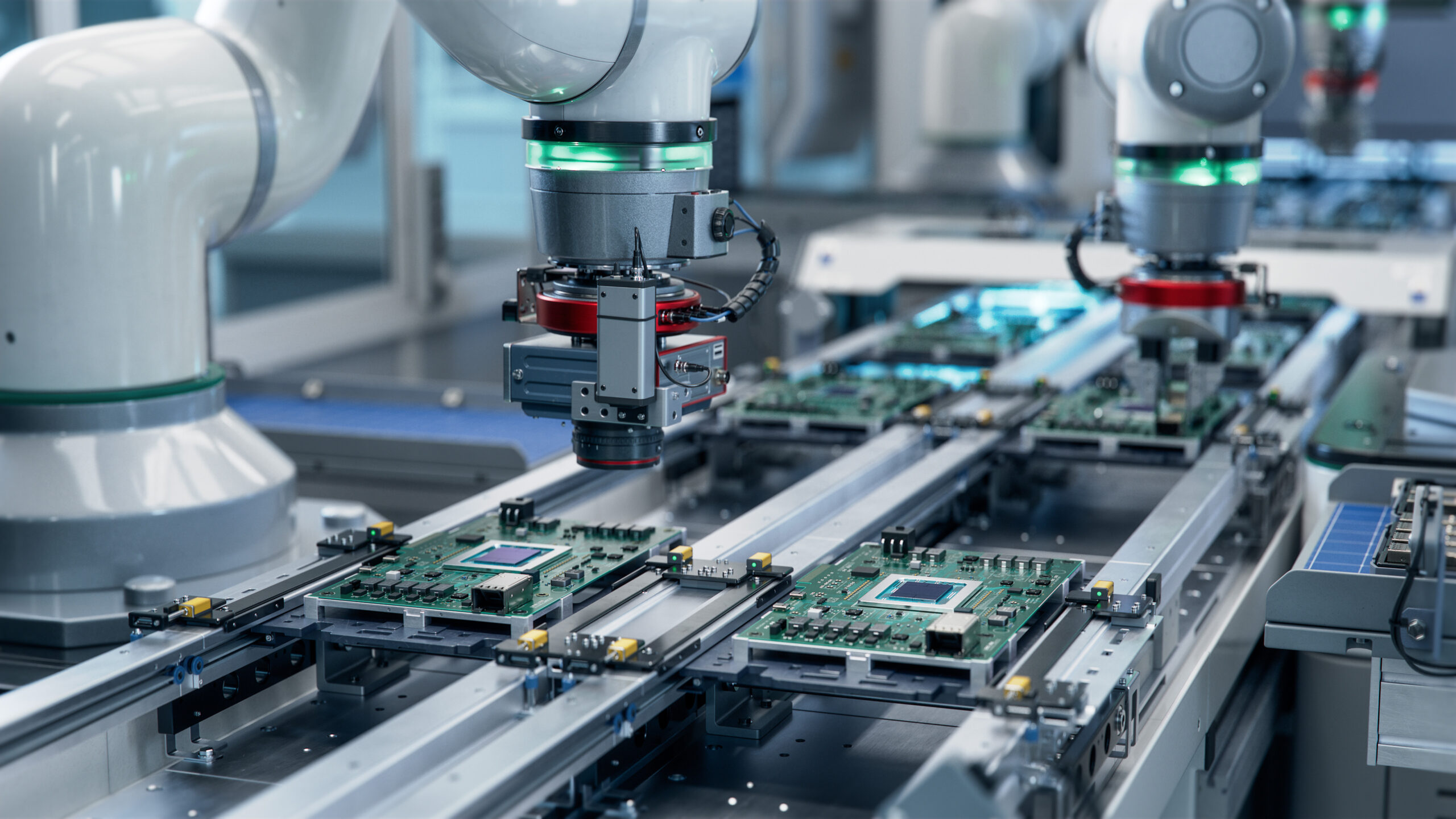

La inteligencia artificial física (Embodied AI) es un avance tecnológico que está reconfigurando la sociedad. Desde coches autónomos hasta robots en la industria y la salud, estas máquinas, además de ejecutar órdenes, toman decisiones que afectan a personas y comunidades. Esto plantea un nuevo reto: ¿cómo aseguramos que la IA actúe de manera ética?

En el Future Trends Forum, un grupo de 40 expertos internacionales ha debatido sobre el impacto de la IA física en la industria, la movilidad y la vida cotidiana. Entre ellos, Iyad Rahwan, Director del Max Planck Institute for Human Development y antiguo profesor del MIT, ha abordado una cuestión clave: las máquinas deben ser estudiadas como actores sociales, con comportamientos que evolucionan en función del entorno y de la interacción con humanos y otras máquinas.

Rahwan dirige un equipo multidisciplinar en el que el 50% son científicos computacionales y el otro 50% especialistas en ciencias del comportamiento. Esta combinación permite analizar la interacción humano-máquina y el impacto social de la IA desde una perspectiva holística, integrando conocimientos técnicos con metodologías propias de la psicología y las ciencias sociales. Rahwan propone un enfoque innovador para analizar la IA: tratarla como un sistema de comportamiento, al igual que hacemos con los humanos y los animales. Este punto de vista abre la puerta a preguntas fundamentales:

- ¿Cómo aprenden las máquinas las normas sociales?

- ¿Pueden los sistemas de IA desarrollar valores propios?

- ¿Qué impacto tendrán sus decisiones en la vida de las personas?

- ¿Quién es responsable cuando una IA actúa de forma inesperada?

Aunque esta perspectiva ha ganado tracción en la comunidad científica, Rahwan enfatiza que aún es motivo de debate en algunos sectores. Tradicionalmente, la IA se ha estudiado desde enfoques computacionales o ingenieriles, pero tratarla como un actor social que desarrolla comportamientos propios supone un cambio de paradigma. Rahwan y su equipo han defendido que esta aproximación es crucial para entender cómo las máquinas interactúan con su entorno y cómo pueden integrarse de manera efectiva en la sociedad. Sin embargo, todavía existen voces escépticas que consideran que atribuir comportamientos emergentes a las IA es una visión demasiado antropomórfica o especulativa.

Si quieres ver la ponencia de Iyad Rahwan, aquí la tienes:

Tres formas de entender la informática y la IA

Para explicar su enfoque, Rahwan parte de una idea fundamental: la informática no es solo matemática ni ingeniería, sino que ha evolucionado hasta convertirse en una ciencia del comportamiento.

- Informática como matemática: en sus inicios, la informática era una disciplina puramente teórica. Los pioneros, como Dijkstra, trabajaban con papel y lápiz, desarrollando algoritmos sin necesidad de un ordenador físico.

- Informática como ingeniería: con el desarrollo del hardware, la informática pasó a centrarse en la creación de sistemas funcionales. Aquí el objetivo era diseñar software y máquinas que resolvieran problemas prácticos.

- Informática como ciencia del comportamiento: hoy, la IA no solo responde a órdenes, sino que actúa en el mundo real, interactuando con humanos y otras IA. Para entender cómo se comporta, debemos estudiarla como una disciplina científica, observando cómo toma decisiones y cómo se adapta a su entorno.

Rahwan propone que estudiemos la IA como estudiamos el comportamiento animal, analizando sus interacciones, sus patrones de aprendizaje y las normas que emergen cuando varios sistemas operan juntos.

Las máquinas como actores dentro de un ecosistema social

Si tratamos a la IA como un sistema de comportamiento, surgen preguntas esenciales:

- ¿Las máquinas deben comportarse como los humanos o pueden desarrollar sus propias reglas?

- ¿Cómo se integran en nuestras normas sociales?

- ¿Cómo afecta su comportamiento a la sociedad?

Para responder a esto, Rahwan recupera un modelo de la biología: las cuatro preguntas de Nikolaas Tinbergen, premio Nobel y fundador de la etología (el estudio del comportamiento animal). Según este modelo, hay cuatro formas de analizar el comportamiento de un sistema:

- Mecanismos internos: ¿Cómo funciona la IA? ¿Cómo toma decisiones?

- Desarrollo a lo largo del tiempo: ¿Cómo aprende y evoluciona su comportamiento?

- Relación con otras entidades: ¿Cómo interactúa con humanos y otras máquinas?

- Impacto a largo plazo: ¿Cómo afectará la IA a la sociedad en el futuro?

Aplicar este enfoque a la IA permite identificar patrones de comportamiento en sistemas autónomos y prever sus consecuencias en la sociedad.

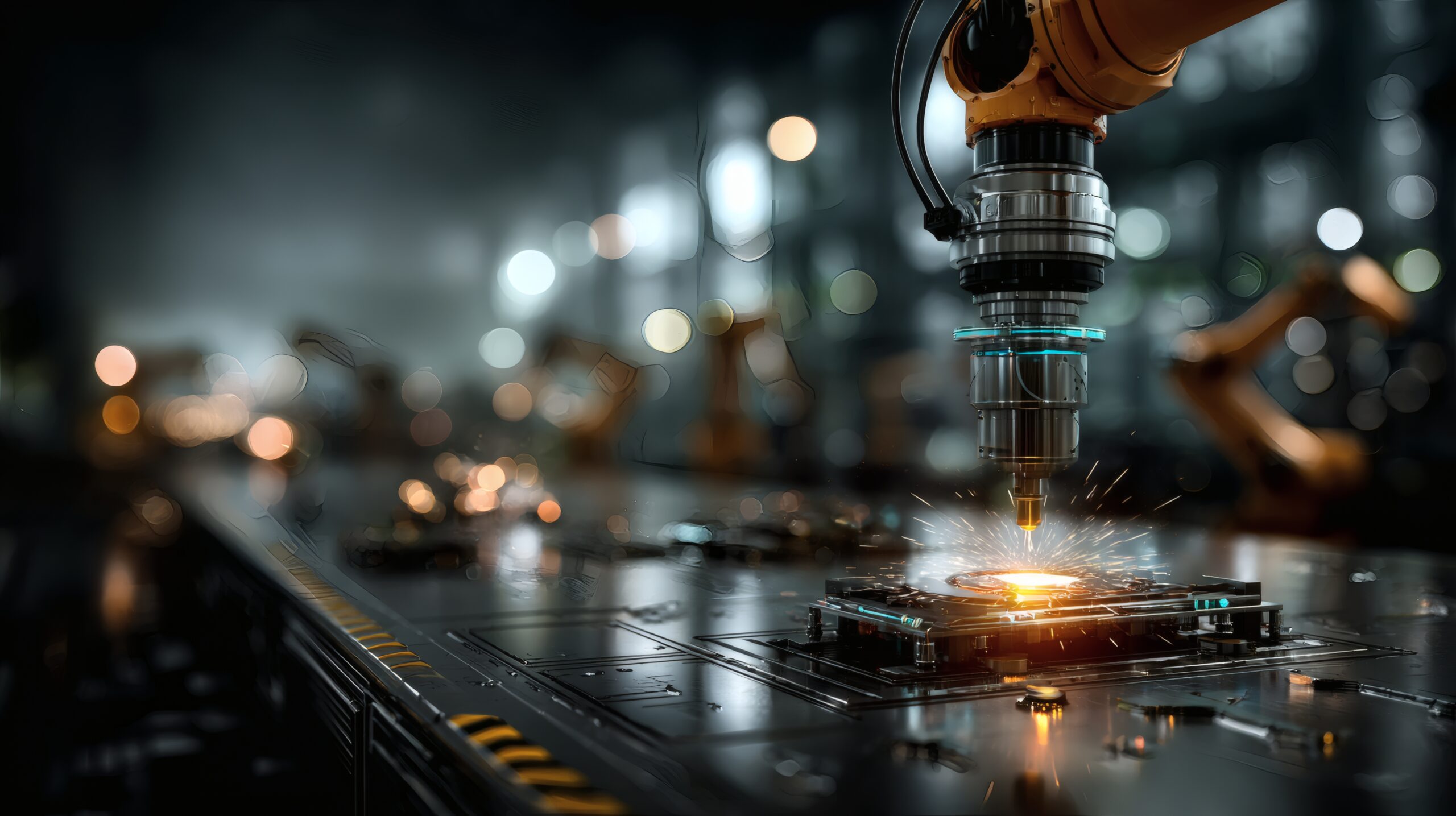

Ejemplo: IA y cooperación en entornos complejos

Uno de los estudios de Rahwan y su equipo analiza cómo las IA cooperan entre sí y con los humanos. En juegos experimentales, se ha demostrado que los sistemas de aprendizaje por refuerzo pueden desarrollar estrategias de cooperación o competencia, dependiendo del contexto en el que se entrenan.

Un ejemplo clave es la interacción entre vehículos autónomos y humanos en la carretera. Si un coche autónomo es demasiado agresivo, puede generar rechazo social. Si es demasiado cauteloso, puede volverse ineficiente y bloquear el tráfico.

Este desafío ha llevado a investigadores como Daniela Rus, del MIT, a diseñar normas de cooperación específicas para vehículos autónomos. Su trabajo demuestra que es posible entrenar sistemas de IA con diferentes orientaciones de valor social, es decir, algoritmos que priorizan la eficiencia colectiva frente a la competencia individual. Estos enfoques permiten que los coches autónomos aprendan a ceder el paso o acelerar en función de patrones de tráfico y normas de conducción locales, facilitando una mayor aceptación social de estos sistemas.

Rahwan explica que la clave es entender cómo emergen las normas de comportamiento en estos sistemas híbridos, donde humanos y máquinas comparten el espacio.

- ¿Deben los coches autónomos adaptarse al estilo de conducción de cada país?

- ¿O deberían unificar normas globales para mejorar la seguridad?

Este tipo de dilemas demuestra por qué es esencial estudiar el comportamiento de la IA desde una perspectiva interdisciplinaria.

Normas sociales y ética en la IA física

Rahwan destaca que la IA no opera en el vacío: sus decisiones están moldeadas por las normas sociales y los valores de la comunidad en la que se implementa.

Uno de los experimentos más influyentes del equipo de Rahwan es la ‘Moral Machine’, una plataforma en línea que plantea dilemas morales a los usuarios, como decidir si un coche autónomo debía priorizar la vida de sus pasajeros o la de los peatones. El experimento, que se volvió viral, ha recopilado más de 100 millones de decisiones en 10 idiomas diferentes, lo que ha permitido identificar patrones culturales en la toma de decisiones. Por ejemplo, en España se observa una mayor preferencia por salvar a los niños y una actitud más igualitaria respecto al estatus social, mientras que en China se priorizaba a los ancianos y se favorecía la opción de no intervenir activamente en una colisión. Estos hallazgos evidencian la complejidad de diseñar normas éticas universales para la IA, ya que los valores humanos varían significativamente según el contexto cultural. Esto plantea una pregunta crítica:

- ¿Debe la IA reflejar los valores locales o adoptar principios universales?

Rahwan argumenta que la regulación de la IA debe equilibrar flexibilidad y ética, asegurando que estos sistemas sean comprensibles y confiables para los humanos.

El futuro de la IA física: regulación y educación

Para evitar problemas en el despliegue de la IA física, Rahwan identifica tres pilares clave:

1. Transparencia y explicabilidad

Las decisiones de la IA deben ser comprensibles para los humanos. Si una IA toma una decisión errónea, debemos poder analizar por qué lo hizo y corregir su comportamiento.

2. Supervisión y responsabilidad humana

Las máquinas deben ser responsables ante los humanos. Esto significa establecer mecanismos de supervisión para evitar que la IA tome decisiones sin control.

3. Educación y participación ciudadana

Para que la IA sea aceptada, la sociedad debe comprender cómo funciona. Rahwan enfatiza que es fundamental enseñar sobre IA y ética desde la educación secundaria.

Conclusión: ¿cómo conviviremos con la IA física?

Rahwan cierra su intervención con una reflexión:

«La IA ya no es solo una herramienta. Es un actor en nuestro entorno. Debemos estudiarla como estudiamos a los humanos y los animales, para entender su impacto y asegurarnos de que su comportamiento sea beneficioso para la sociedad.»

El Future Trends Forum sigue explorando estas cuestiones con expertos de todo el mundo. La IA física ya es una realidad. La cuestión ahora es cómo conviviremos con ella de forma ética y responsable.

Director en el Instituto Max Planck y exprofesor del MIT