Quantum computing

Quantum computing, el paradigma que ha dejado pequeños a los superordenadores

En el primer #FutureTalks hablaremos de una tecnología que promete cambiar el mundo de la computación: Quantum Computing.

En 1959, Richard Feynman arrojó un guante al mundo tecnológico. En su famosa charla, conocida como There’s Plenty of Room at the Bottom, el padre del quantum computing ya hablaba de nanotecnología y de ordenadores que se basaran en los principios de la física cuántica para funcionar.

Más de 20 años después tuvo lugar la primera conferencia sobre quantum computing en el Massachusetts Institute of Technology (MIT). Y en 1985, David Deutsch describió el primer ordenador cuántico universal, apoyándose en los planteamientos de Turing y Church, en los postulados que ya se habían dado a principios del siglo XX sobre la mecánica cuántica y en las ideas de Feynman.

Se iniciaba así un camino que nos permitirá ir un paso más allá de la computación tradicional, abriendo un universo de posibilidades a escala microscópica y velocidad nunca antes concebida.

Los ordenadores cuánticos, más allá del nanómetro

Puede que cuando hablemos de potencia de procesamiento, lo primero en lo que pensemos sea en los superordenadores. Al igual que el que tienes en casa, los superordenadores funcionan con a base de chips que procesan la información en forma de bits, cuyo valor puede ser 1 o 0, y puertas lógicas que se activan o desactivan en función de estos bits.

La carrera tecnológica de los últimos veinte años ha tratado de reducir cada vez más el tamaño de estos chips, a la vez que incrementaban su potencia de procesamiento exponencialmente. Y lo ha hecho con éxito.

Sin embargo, nos estamos acercando al final de este camino. Cuanto menor es el tamaño del chip, mayores son las posibilidades de que los electrones que circulan por él transmitiendo la información —los 0 y 1 que mencionábamos antes— se escapen de los canales por los que tienen que ir.

Este ‘“efecto túnel’” se debe a que los electrones son partículas subatómicas que pueden comportarse como ondas y atravesar las paredes físicas de esos canales que, de otra manera, no podrían salvar. Esto es, precisamente, lo que puede provocar esos escapes y el consiguiente mal funcionamiento del chip.

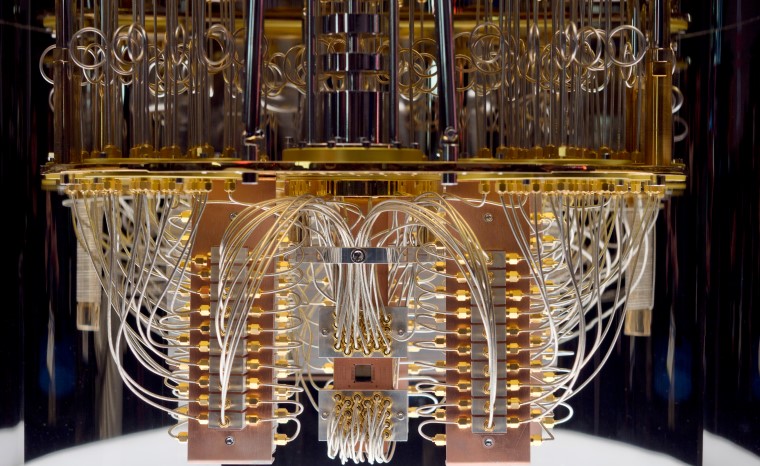

Los chips que se utilizan en los ordenadores cuánticos no tienen este problema, pero sí exigen una serie de requisitos que no son fáciles de satisfacer. Necesitan estar a temperaturas extremadamente bajas (unos 173 grados bajo cero), estar aislados de vibraciones y golpes, sin interferencia alguna del entorno que los rodea y, por supuesto, totalmente blindados a cualquier campo magnético exterior.

En la actualidad, compañías como IBM están desarrollando computadores a base de circuitos hechos con materiales superconductores, que permiten cumplir estos requisitos. También recurren a superfluidos para refrigerar estos circuitos y cumplir con la demanda de temperatura. El objetivo último es que los qubits, las unidades básicas de información en quantum computing, mantengan su estado frágil cuántico, clave para el correcto funcionamiento de estos ordenadores.

¿Merece la pena el quantum computing?

Viendo lo complejo de estos requerimientos, podríamos pensar que no merece la pena apostar por este tipo de computación. Pero, por un lado, cabe aclarar que la idea no es que todos tengamos un ordenador cuántico en casa. El plan de las empresas que están liderando esta carrera, como Google, IBM o Microsoft, es facilitar acceso en remoto a este tipo de computadoras, de manera que se pueda aprovechar todo su potencial sin necesidad de instalar en casa un PC del tamaño de un frigorífico.

Por otro lado, cumplir con todas las demandas necesarias de este tipo de ordenadores se justifica simplemente con entender la velocidad de procesamiento que pueden llegar a alcanzar.

Los chips que se utilizan en los ordenadores cuánticos no funcionan según la lógica de ceros y unos que solo permite esos dos estados: verdadero o falso. En lugar de bits, que solo pueden tener un único valor, se utilizan qubits, que son capaces de tener, de manera simultánea, valor 0, 1 y todos los infinitos estados intermedios entre ambos. Esto les permite resolver problemas de manera mucho más eficiente y rápida.

En este vídeo se aprecia la diferencia entre el comportamiento de un ordenador tradicional y un ordenador cuántico.

En algo tan sencillo como un laberinto, la diferencia salta a la vista. Pero si imaginamos problemas más complejos de combinatoria, como el que puede tener una empresa a la hora de analizar la forma óptima de repartir el riesgo en su cartera de inversiones, la potencia del quantum computing es muchísimo mayor que la de la lógica tradicional.

Las ventajas únicas del quantum computing

Para poder sacar el máximo rendimiento al quantum computing es necesario desarrollar algoritmos ad hoc que sepan aprovecharse de algunos fenómenos únicos que se dan en los qubits.

Ya hemos hablado de la superposición, que es la capacidad que tiene un qubit para representar diferentes estados de manera simultánea. Como señalan en el MIT, esta “habilidad” permite que un ordenador cuántico pueda manejar una cantidad muy alta de posibles resultados solo con unos pocos qubits. En estos casos, el resultado final del cálculo se obtiene cuando los qubits son medidos, lo que produce que su estado cuántico se colapse y pase a ser 0 o 1.

El entrelazamiento es otra de las cualidades de los qubits que les hacen tan interesantes a la hora de procesar información. Consiste en que dos qubits se entrelazan y se encuentran en el mismo estado cuántico, incluso aunque no estén en contacto directo. Como resultado de esto, si uno de los dos qubits cambia de estado, el otro también lo hace.

Este tipo de fenómenos hacen que los algoritmos tradicionales no tengan razón de ser en lo que se refiere al quantum computing. Es necesario que los algoritmos que utilicen estos ordenadores aprovechen todo el potencial que ofrecen los qubits. Y un ejemplo de esto es el algoritmo de Grover.

Si utilizamos un ordenador tradicional para realizar una búsqueda en una lista de N elementos, la media de elementos que tendremos que procesar hasta encontrar lo que buscamos es N/2. Sin embargo, con el algoritmo de Grover y un ordenador cuántico, la media se reduce a la raíz cuadrada de N, un nivel de eficiencia muy superior a lo que teníamos disponible hasta ahora. Si hablamos de tiempo, la diferencia se hace aún más patente. En un ordenador tradicional, encontrar un elemento determinado en una lista de un trillón de ítems llevaría una semana. En un ordenador cuántico en el que utilizáramos este algoritmo, nos llevaría un segundo.

En la actualidad, nos encontramos en un momento emocionante en lo que al quantum computing se refiere. Hace poco más de un año, Google publicaba que había sido capaz de alcanzar la supremacía cuántica, que consiste en demostrar empíricamente que un ordenador cuántico ha sido capaz de realizar una operación matemática prácticamente imposible de realizar para un ordenador tradicional.

IBM no tardó en replicar, analizando el experimento y exponiendo que, pese a lo admirable del experimento, la realidad es que esa supremacía aún está por conseguir. Lo que sí es cierto es que vivimos en una era en la que las posibilidades del quantum computing están a punto de despegar.

El 27 de mayo tendremos una ocasión excepcional de aprender sobre Quantum Computing de la mano de uno de los referentes en este desarrollo: Dario Gil. Te esperamos!