Resumen generado por IA

Los asistentes de voz, presentes en teléfonos, altavoces inteligentes y televisores, funcionan gracias a avanzados sistemas de aprendizaje automático que imitan la manera en que aprenden los niños: mediante práctica, ensayo y error, y refuerzos positivos. Inicialmente, estos asistentes no entienden el habla, pero mejoran progresivamente al recibir «recompensas digitales» cuando transcriben correctamente, un proceso que requiere millones de horas de entrenamiento. Aunque parten de bases con grabaciones y transcripciones previas, aún dependen de la intervención humana para corregir y mejorar su desempeño, enviando fragmentos de audio anonimizados a trabajadores que ayudan a ajustar sus algoritmos.

Más allá de transcribir palabras, los asistentes deben interpretar el significado y contexto, un desafío complejo especialmente con palabras polisémicas como «tiempo», cuyo sentido varía según la frase. Para ello, utilizan técnicas como la vectorización del texto, que relaciona palabras entre sí, similar a cómo el cerebro humano entiende las conexiones semánticas. Además, el aprendizaje es colaborativo y acumulativo: los dispositivos comparten datos en red, potenciando el conocimiento colectivo sin necesidad de enseñanza individual, ejemplificando el poder exponencial del Big Data en la mejora continua de estas tecnologías.

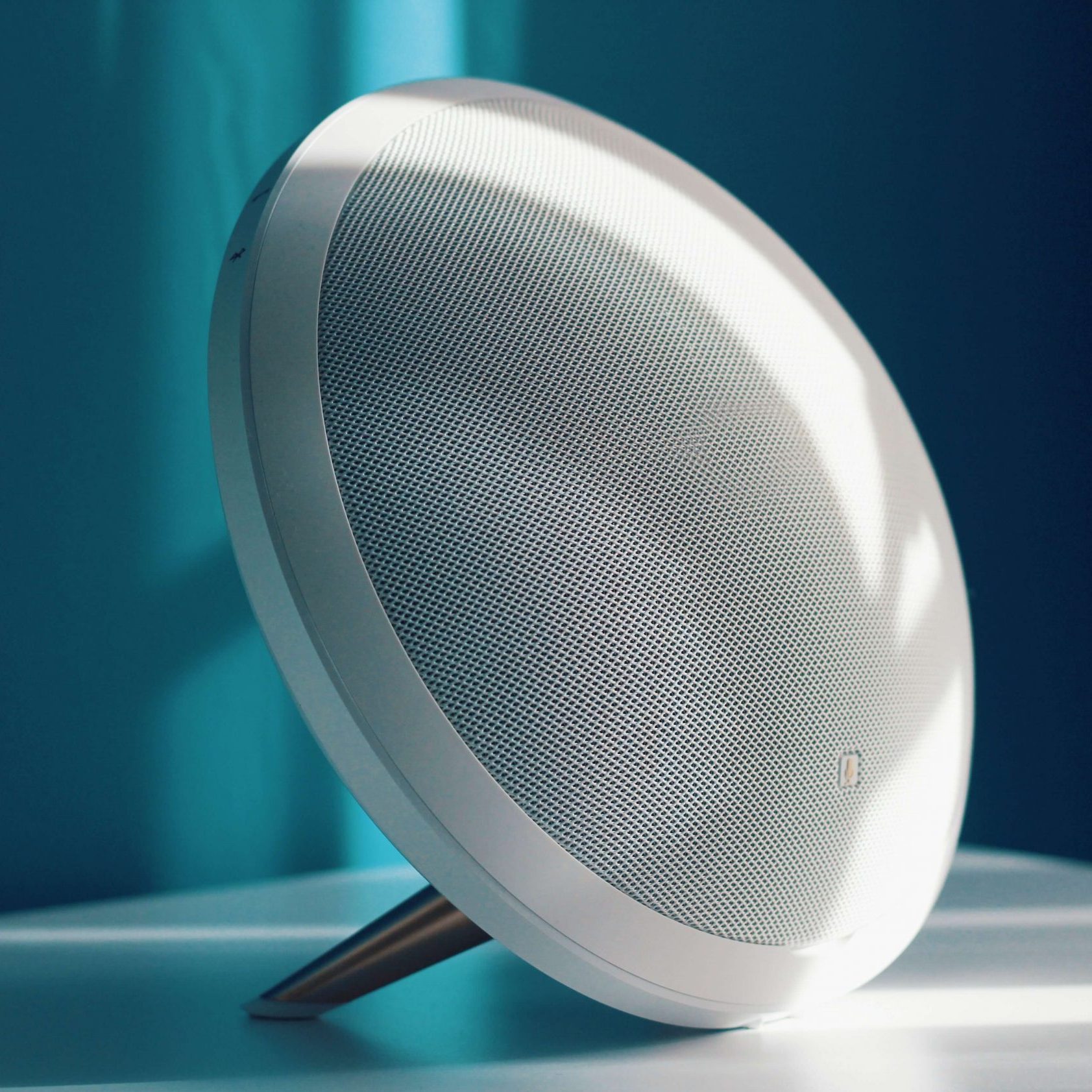

Entre los ejemplos prácticos del uso de Big Data están los asistentes de voz, programas capaces de escucharnos y ofrecer una respuesta acorde.

Los asistentes de voz son herramientas ubicuas. Están instalados por defecto en todos los teléfonos, pero también están presentes en altavoces inteligentes o integrados en televisores. Su “entendimiento” del habla es un ejemplo práctico de Big Data pero, ¿cómo aprenden los asistentes de voz? ¿Por qué funcionan tan bien? ¿Cómo saben lo que queremos de ellos?

Aprendizaje automático por refuerzo, como los niños

En principio, los asistentes de voz aprenden de la misma forma en que lo hace un niño: con práctica, con errores y con refuerzos. En machine learning el refuerzo es una recompensa —o la falta de un “castigo”— cuando algo se ha hecho bien.

Lo más probable es que el primer asistente de voz no “entendiese” ni una sola palabra, por lo que no recibía ningún “premio” digital cuando trataba de transcribir a las personas.

Pero estos sistemas están programados para probar con pequeñas variaciones que les ayuden a “acertar equivocándose”, como un niño que dice veinte veces mal una palabra hasta que un día la dice bien. Es entonces cuando se le felicita, e integra esa recompensa —emocional en los niños, digital en máquinas— al aprendizaje. Así es como se premia el aprendizaje.

Millones de horas de ensayo y error

Por descontado, los asistentes de voz no parten de una tabula rasa o en blanco, sino que lo hacen con grabaciones y transcripciones previas almacenadas en su memoria. Esto es una ventaja respecto a las personas, aunque no quiere decir que lo tengan todo de su parte. Aprender es un mecanismo complejo que exige millones de horas de ensayo y error.

Aunque parte del proceso de aprendizaje está automatizado, aún hace falta mano de obra humana para mejorar los asistentes de voz. Por ello, de tanto en tanto, pequeñas fracciones inconexas y anonimizadas de audio son enviadas a trabajadores para que las escuchen y transcriban. Algo parecido a los CAPTCHA, pero con sonido en lugar de imágenes. Por eso nos entienden casi siempre.

El sentido de las oraciones: transcribir versus interpretar

Las máquinas virtuales necesitan millones de horas de práctica para refinar sus algoritmos e interpretar oraciones sencillas porque no todo es entender el texto asociado al audio. Eso, que supone un ejemplo de hitos del Big Data, es la parte fácil. La compleja es saber qué quiere el humano cuando dice una frase. La interpretación o comprensión del audio y texto asociado.

Particularmente complejas son las interpretaciones de palabras polisémicas. Cuando alguien usa la palabra “tiempo”, ¿está preguntando por la hora, por la cantidad de minutos que faltan para algo, por la meteorología, por el sentido de la oportunidad, por la edad de alguien? Sin contexto, “tiempo” es una palabra que carece de valor. Necesita otras palabras que la complementen.

Para poder interpretar, a las máquinas se les da un “mapa” llamado vectorización del texto con una serie de vectores que transcriben las relaciones de cada palabra respecto a todas las demás palabras. El cerebro humano hace algo parecido aunque no seamos conscientes, por eso sabemos que “vaso” está relacionado con “agua”, pero que si hablamos de “vino”, “copa” está más cerca que “vaso”. Ese tipo de sutilezas es clave.

Los asistentes de voz aprenden con la experiencia que, en su caso, es acumulativa. Se trata del ejemplo práctico de que el Big Data es exponencial. Un altavoz no aprende por sí mismo. En su lugar, comparte datos con toda la red de altavoces y móviles que usan el mismo sistema. Además, no olvidan, ni necesitan transferir el conocimiento de forma oral o escrita a la siguiente generación.