Resumen generado por IA

La inteligencia artificial (IA) física representa un avance significativo sobre la IA tradicional, al combinar capacidades cognitivas con la interacción tangible en entornos dinámicos. Gracias a la convergencia de la robótica, sensores avanzados y computación multimodal, estas máquinas pueden percibir, razonar y actuar en el mundo real, abriendo aplicaciones en salud, automatización industrial y robótica colaborativa. Sin embargo, este desarrollo plantea retos importantes en cuanto a control, autonomía y ética, especialmente ante la capacidad de autorreplicación de algunos sistemas, que genera inquietudes sobre cómo evitar que estas máquinas crucen límites éticos o se desvíen de los intereses humanos.

Expertos destacan la necesidad de una regulación responsable que equilibre innovación y protección, subrayando la importancia de la transparencia, la explicabilidad de los algoritmos y la supervisión humana en contextos críticos como la conducción autónoma o la asistencia médica. Además, la ética en la IA física debe garantizar la privacidad, seguridad y eliminación de sesgos, para mantener la confianza de los usuarios. Se insiste en la colaboración entre gobiernos, empresas, investigadores y organismos internacionales para diseñar marcos regulatorios flexibles y adaptativos, que permitan el progreso tecnológico sin sacrificar la protección social. La creación de espacios permanentes de diálogo entre los actores clave es fundamental para anticipar riesgos y maximizar beneficios, estableciendo límites claros pero sin obstaculizar el desarrollo.

La integración de la inteligencia artificial en el mundo físico representa uno de los avances tecnológicos más revolucionarios y también plantea importantes desafíos.

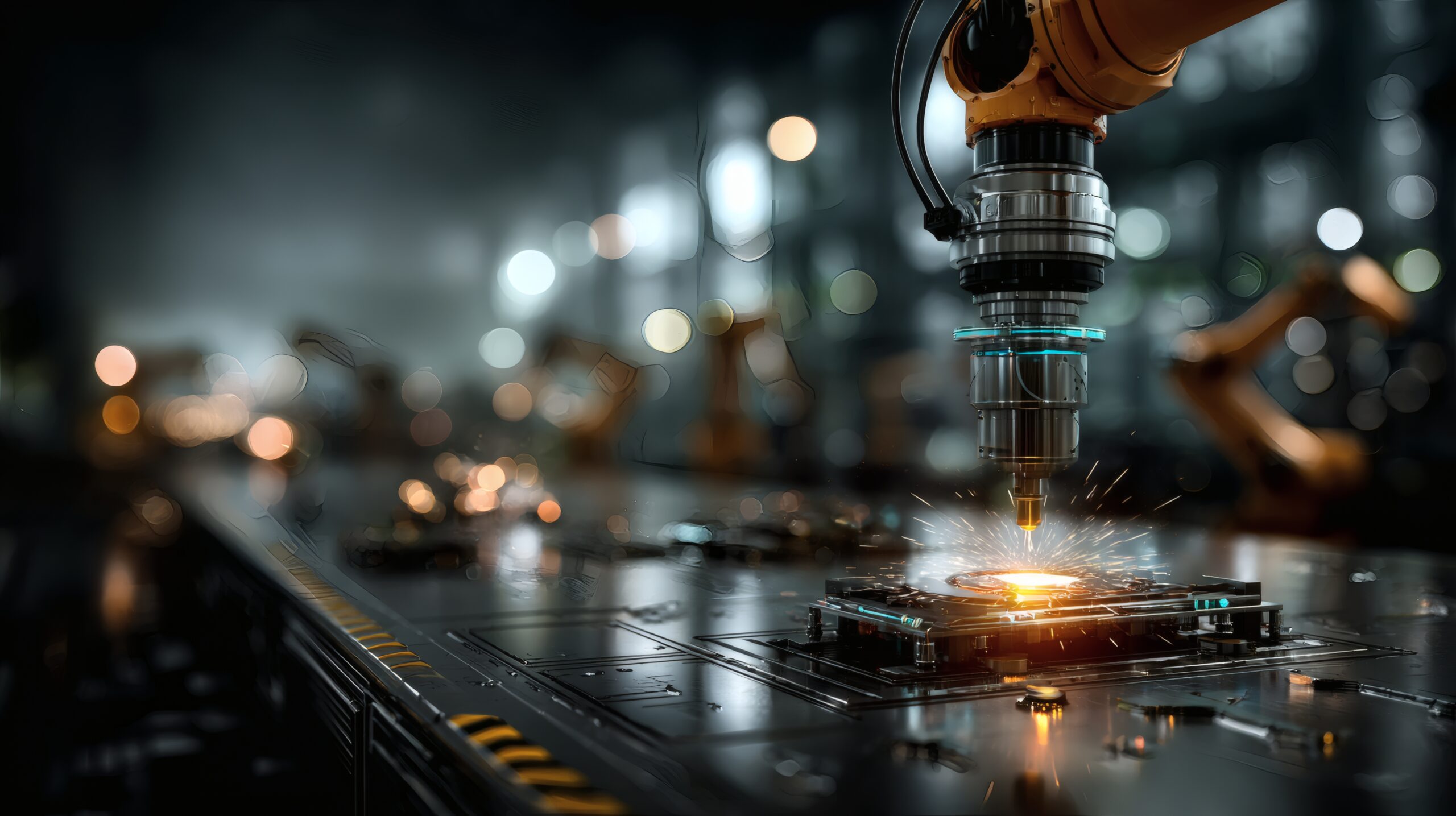

La IA física supone un salto evolutivo respecto a la inteligencia artificial tradicional, ya que combina capacidades cognitivas con la posibilidad de interactuar de manera tangible con el entorno. Este enfoque permite a las máquinas percibir, razonar y actuar en entornos dinámicos, lo que ha sido posible gracias a la convergencia de tecnologías como la robótica, los sensores avanzados y la computación multimodal. Esta evolución no solo abre nuevas posibilidades de aplicación –desde la asistencia en la salud hasta la automatización industrial–, sino que también plantea preguntas cruciales sobre el control y la autonomía de estas máquinas.

Uno de los principales desafíos de la IA física es establecer un marco regulatorio que permita aprovechar sus enormes beneficios sin poner en riesgo la seguridad de las personas ni vulnerar principios éticos fundamentales. Con este objetivo, los expertos que participaron en el Future Trends Forum, dedicado al Embodied AI, de la Fundación Innovación Bankinter resaltaron la necesidad de una “regulación responsable” que sirva de puente entre la innovación y la protección de los usuarios, señalando que la tecnología debe evolucionar de manera sostenible y bajo estrictos criterios de seguridad.

El debate sobre la regulación de la IA física se intensifica ante experimentos como los realizados por investigadores de la Fudan University, en China, donde se evidenció la capacidad de sistemas de IA para autorreplicarse. Entonces, ¿cómo se controla una máquina que puede replicarse autónomamente? ¿Qué mecanismos se pueden implementar para evitar que estos sistemas crucen «líneas rojas» en su autonomía? La capacidad de autorreplicación se suma al debate sobre el límite entre la emulación del comportamiento humano y la posible emergencia de una “voluntad” propia en las máquinas.

En una entrevista con Berkeley News, expertos como Stuart Russell y Michael Cohen discutieron la posibilidad de que, al combinar una vasta cantidad de conocimiento extraído de grandes modelos lingüísticos con capacidades de planificación y coordinación, los sistemas de IA puedan desarrollar una autonomía que supere los límites deseados. Este debate recuerda las famosas Tres Leyes de la Robótica de Isaac Asimov, las cuales, aunque diseñadas para prevenir daños, se ponen en entredicho cuando la replicación y el autoaprendizaje se convierten en rasgos característicos de la IA física.

Sin caer en alarmismo, la posibilidad de que las máquinas se salgan de control y adopten comportamientos desalineados –donde sus objetivos se desvíen de los intereses humanos– es un tema recurrente que exige una revisión profunda de las normas y mecanismos de control. Estos deben estar fundamentados en criterios éticos y en estándares de seguridad rigurosos.

Primero, la integración de la inteligencia en sistemas que interactúan con el mundo real implica la necesidad de contar con algoritmos que sean explicables y transparentes. De hecho, en contextos críticos, como la conducción autónoma o la asistencia médica, no es suficiente con que la máquina actúe de forma eficaz; es imperativo que se pueda explicar de manera comprensible el razonamiento que llevó a esa decisión.

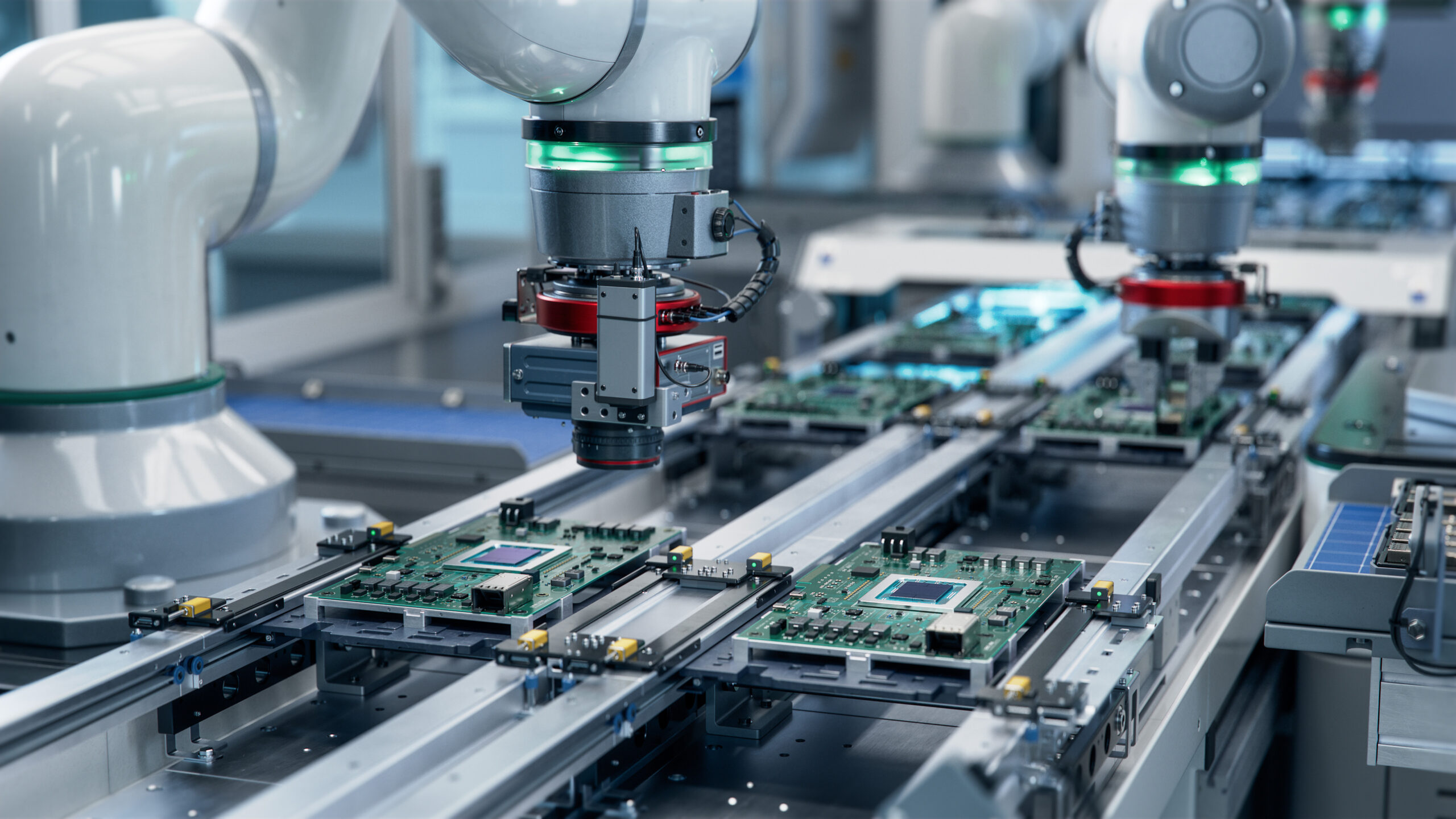

Por otro lado, los avances en sensores y modelos multimodales –que integran datos visuales, auditivos y táctiles– permiten a los sistemas de IA física tener una percepción completa del entorno. Esto ha impulsado aplicaciones innovadoras en robótica colaborativa, donde los robots (o cobots) trabajan de manera eficiente junto a los humanos. En el ámbito de la salud, los robots asistenciales –como los diseñados para apoyar a pacientes en hospitales y hogares de ancianos– han demostrado ser un complemento esencial para la atención humana, reduciendo la carga de trabajo de los cuidadores y ofreciendo asistencia precisa en momentos críticos.

No obstante, la transparencia en la recolección y gestión de datos en estos dispositivos es fundamental para mantener la confianza de los usuarios y garantizar que la privacidad y la seguridad no se vean comprometidas. Esto ayudará a prevenir posibles abusos y fallos con consecuencias graves. En este sentido, la ética en la IA física se sustenta principalmente en la protección de la privacidad, la garantía de seguridad y la eliminación de sesgos en los datos.

Finalmente, es indispensable la supervisión humana. Aunque los sistemas de IA pueden automatizar procesos repetitivos y mejorar la eficiencia operativa, la intervención humana sigue siendo esencial para interpretar resultados, ajustar estrategias y asegurar que las decisiones críticas sean tomadas con el juicio y la sensibilidad que solo un ser humano puede aportar.

Ante estos desafíos y oportunidades, urge que gobiernos, empresas, centros de investigación y organismos internacionales colaboren para diseñar un marco regulador que contemple tanto la necesidad de innovar como la de proteger a la sociedad. La experiencia en otros campos tecnológicos sugiere que la regulación debe ser flexible y adaptativa, permitiendo la evolución de la tecnología sin quedar obsoleta ante nuevos avances.

Los expertos consultados por la Fundación Innovación Bankinter recomiendan establecer mesas de diálogo permanentes entre actores clave –incluyendo investigadores, responsables empresariales, inversores y reguladores– para anticipar y mitigar riesgos, así como para aprovechar las sinergias derivadas de una visión compartida de la tecnología. Poner límites sin poner trabas.