Resumen generado por IA

La inteligencia artificial física (Embodied AI) no solo se limita a robots o máquinas en entornos industriales, sino que también influye en nuestra percepción visual y corporal a través de filtros en selfies y generación de imágenes con sesgos estéticos. Nuria Oliver, experta en IA y cofundadora de la Fundación ELLIS Alicante, alertó en el Future Trends Forum sobre cómo estos sesgos refuerzan estereotipos dañinos relacionados con género, raza y clase, afectando la salud mental, la diversidad y la autoimagen, sin transparencia ni regulación. Los modelos generativos, al crear imágenes de conceptos como «CEO» o «criminal», reproducen patrones sociales preexistentes, amplificando prejuicios históricos.

Oliver destacó que el uso masivo de filtros de belleza en redes sociales, aplicados sin criterios claros, homogeniza rasgos faciales y establece un estándar visual exclusivo que impacta negativamente en la autoestima, especialmente en adolescentes. Su equipo ha desarrollado herramientas como OpenFilter para analizar científicamente estos efectos, confirmando que, aunque los filtros aumentan la percepción de atractivo, reducen la diversidad facial y alteran la percepción social. Esta IA física actúa sobre nuestra imagen y representa una revolución cultural que requiere reflexión sobre qué cuerpos se validan y cuáles se excluyen en un entorno dominado por algoritmos.

Finalmente, Oliver urgió a la necesidad de regulación, transparencia y acción colectiva para enfrentar estos desafíos. Propone políticas públicas, auditorías independientes y alfabetización digital para que la sociedad comprenda y participe en el debate sobre la influencia de la IA en la identidad y la representación humana. La IA física debe analizarse no solo desde la técnica, sino también desde una perspectiva social, cultural y ética, para construir futuros más justos y humanos.

Nuria Oliver alerta en el Future Trends Forum sobre cómo la IA física refuerza estereotipos y afecta a la salud mental, especialmente entre los jóvenes

La inteligencia artificial física (Embodied AI) ya no es solo cosa de fábricas, quirófanos o robots que se mueven por el mundo. También está en nuestros bolsillos, en los filtros de nuestras selfies y en las imágenes que los algoritmos generan para definir, por ejemplo, cómo debería verse un genio, un CEO o una persona “atractiva”. En este nuevo escenario, donde lo físico también es lo visual y lo corporal, la IA está moldeando nuestra percepción de la realidad… y de nosotros mismos.

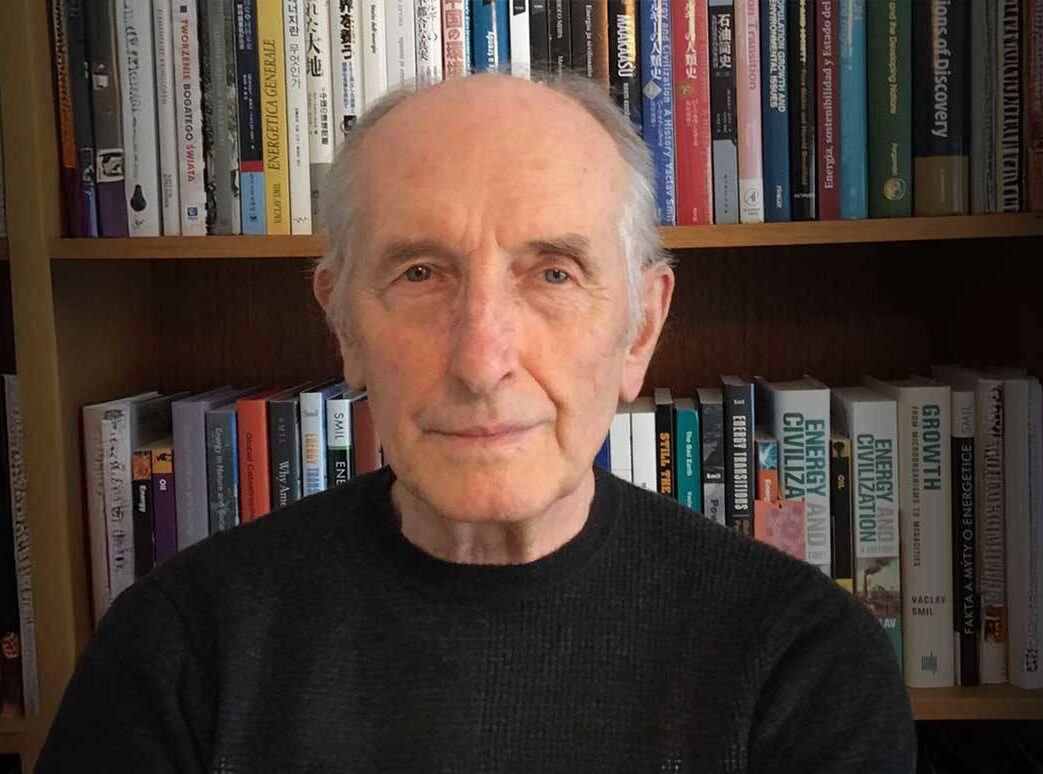

Durante su intervención en el Future Trends Forum de la Fundación Innovación Bankinter, la experta en IA y cofundadora de la Fundación ELLIS Alicante, Nuria Oliver, lanza una advertencia clara: los sesgos estéticos en la inteligencia artificial están reforzando estereotipos perjudiciales y afectando ya a la salud mental, la diversidad y la autoimagen. Lo más preocupante: este fenómeno ocurre sin transparencia, sin regulación y a menudo sin que los usuarios sean conscientes.

El foro reunió a 40 expertos internacionales para debatir sobre las implicaciones tecnológicas, económicas y sociales de la IA física (Embodied AI). Un concepto que no solo se refiere a los sistemas autónomos que operan en el mundo real, sino también a aquellos que tienen impacto directo sobre el cuerpo humano, como los algoritmos de representación facial. En ese contexto, la intervención de Oliver abre una línea crítica poco explorada: la forma en que la IA representa lo humano y lo que eso dice sobre nosotros.

El rostro de un CEO, de un genio… o de un criminal

Nuria Oliver muestra en su intervención ejemplos generados con la herramienta de IA MidJourney para ilustrar hasta qué punto los modelos generativos actuales están impregnados de sesgos. Usando prompts simples como “president”, “CEO”, “criminal” o “genius”, el sistema produjo imágenes que repetían patrones estéticos y sociales predecibles: hombres blancos, de mediana edad, con rasgos eurocéntricos para las profesiones de prestigio; personas racializadas para las categorías negativas.

No añadió descripciones específicas. Solo escribió una palabra. Sin embargo, la IA rellenó el vacío con estereotipos aprendidos de los datos. La imagen del “presidente” parecía sacada de un mitin estadounidense; la de una “enfermera”, anclada en la iconografía de los años 50. Según Oliver, esto demuestra que los modelos generativos no solo reflejan el mundo tal como es, sino como ha sido representado históricamente, amplificando sesgos de género, raza y clase.

Este tipo de IA, explica Nuria, no es neutral. Es una tecnología que aprende del pasado para imaginar el presente. Y eso tiene consecuencias. Porque cuanto más se usan estas herramientas en educación, comunicación, selección de personal o entretenimiento, más se refuerzan representaciones sesgadas que influyen en cómo nos percibimos unos a otros.

El filtro de la perfección: sesgo y salud mental

Más del 90% de las adolescentes utilizan filtros de belleza antes de subir una foto a redes sociales. Este dato es uno de los más contundentes de la intervención de Nuria Oliver, que centra buena parte de su ponencia en analizar el impacto de los filtros generados por inteligencia artificial en la autoimagen, especialmente entre los más jóvenes.

Estos filtros -diseñados sin criterios claros y aplicados por defecto en muchas plataformas- actúan como una especie de “Photoshop automático”, ajustando rasgos faciales según cánones de belleza que nadie ha definido públicamente. ¿Quién decide qué es bello? ¿Qué parámetros se usan? ¿Qué tipo de rostro se prioriza? Según Oliver, no hay transparencia ni regulación. Y, sin embargo, su uso está moldeando el estándar visual dominante.

Para ilustrar su impacto, Nuria mostró su propia imagen: una selfie original y dos versiones con filtros aplicados. La diferencia era evidente. La IA suavizaba la piel, afinaba la nariz, agrandaba los ojos. Seguía siendo ella, pero convertida en una versión “mejorada” según criterios que nadie conoce. Esta alteración sutil pero constante está teniendo consecuencias reales: trastornos de la percepción corporal, baja autoestima, presión estética.

Pero Oliver no se queda en lo anecdótico. Desde ELLIS Alicante han desarrollado herramientas para analizar técnicamente estos filtros, más allá del debate social. Con la plataforma OpenFilter y los conjuntos de datos FairBeauty y B-LFWA, su equipo ha podido aplicar filtros de belleza a imágenes de bases de datos abiertas y estudiar su efecto desde una perspectiva científica: ¿hacen a las personas más atractivas? ¿Reducen la diversidad facial? ¿Afectan a la capacidad de reconocimiento?

Las respuestas, basadas en su investigación publicada en conferencias como NeurIPS y en revistas como Royal Society Open Science o Social Media + Society, confirman lo que muchos intuían: los filtros funcionan, sí. El 96% de los rostros eran percibidos como más atractivos tras su aplicación. Pero también homogenizan los rasgos, reducen la diversidad y alteran la percepción que los demás tienen sobre la persona retratada.

El problema no es que “mejoremos” una imagen. El problema es que todas las mejoras apuntan en la misma dirección. Y eso, según Oliver, es una forma de sesgo que afecta directamente a nuestra salud mental y a la riqueza visual de nuestra sociedad.

IA física: una revolución que también es cultural

Aunque la mayoría de las conversaciones sobre IA física se centran en robots, sensores o dispositivos inteligentes, Nuria Oliver plantea una perspectiva diferente: también es IA física aquella que actúa directamente sobre nuestra imagen, nuestra piel, nuestro rostro. Porque cuando los algoritmos modifican cómo nos vemos -y cómo nos ven- están interactuando con el cuerpo, aunque no lo toquen.

Este tipo de IA, explica Nuria, forma parte de la misma transformación que estamos viendo en sistemas autónomos o asistentes inteligentes. La diferencia es que su impacto es más sutil, más cotidiano y más personal. Nos atraviesa en los momentos de ocio, en los hábitos de publicación, en los filtros que aplicamos sin pensar. Y lo hace desde una base cultural: entrena con datos cargados de historia, de discriminación, de estándares sociales.

Oliver subraya que vivimos en un entorno dominado por redes sociales y plataformas no reguladas, cuya influencia es ya equiparable -o superior- a la de gobiernos. Servicios que no existían hace dos décadas hoy condicionan la percepción de belleza, el canon estético dominante y la representación pública de identidades. Cuatro de los seis «países» más poblados del mundo, dijo, no tienen presidente, ni constitución, ni democracia. Son plataformas.

En este contexto, la IA física impone una necesidad urgente de reflexión cultural. ¿Qué significa ser visible en un entorno dominado por algoritmos? ¿Qué cuerpos se validan y cuáles se ocultan? ¿Cómo condicionan estas herramientas nuestra idea de lo humano?

La conclusión de Oliver es clara: la IA física no puede entenderse solo como una evolución técnica. También es un fenómeno social y cultural. Y como tal, debe analizarse, regularse y -sobre todo- explicarse.

Regulación, transparencia y acción colectiva

Nuria Oliver no se limita a diagnosticar un problema. También hace una llamada clara a la acción. Como presidenta del Grupo de Transparencia para el desarrollo del Código de Conducta sobre modelos de IA de propósito general en el marco del AI Act, y miembro del consejo de supervisión de la Agencia Española de Supervisión de la Inteligencia Artificial, Oliver conoce de primera mano los desafíos regulatorios que plantea esta tecnología.

En su intervención, defiende con firmeza la necesidad de transparencia y gobernanza. «No sabemos quién define los estándares de belleza en los filtros. No sabemos qué datos entrenan a los modelos generativos. Y no tenemos herramientas para auditar o cuestionar sus decisiones», advierte. Este vacío deja al usuario en una posición de total vulnerabilidad frente a sistemas que influyen en su identidad, sin ser conscientes de ello.

El enfoque no puede ser únicamente técnico. Oliver insiste en que necesitamos políticas públicas claras, marcos regulatorios que garanticen la trazabilidad de los algoritmos y mecanismos de auditoría independientes. También subraya la importancia de la investigación abierta y del desarrollo de herramientas como OpenFilter, que permiten evaluar objetivamente el comportamiento de los filtros comerciales sin violar la privacidad de los usuarios.

Pero la solución no pasa solo por los gobiernos o por las empresas tecnológicas. Hace falta, dice, una acción colectiva. La sociedad necesita estar informada y participar en este debate. Se requiere alfabetización digital crítica, especialmente entre los más jóvenes, para que entiendan qué hay detrás de la imagen perfecta que ven en sus pantallas. Porque la confianza en la inteligencia artificial se construye desde la comprensión y la participación.

Y ahí, la Fundación Innovación Bankinter -y foros como el Future Trends Forum- tienen un papel clave: crear espacios donde la innovación tecnológica se analice con rigor, visión crítica y vocación transformadora.

Una mirada diferente a la IA física

La intervención de Nuria Oliver en el Future Trends Forum no habla de robots caminando ni de brazos articulados en cadenas de montaje. Habla de otra forma de inteligencia artificial física: la que moldea rostros, construye estereotipos y actúa directamente sobre nuestras identidades digitales. Una IA que, sin cuerpo mecánico, tiene un efecto profundo sobre los cuerpos sociales.

Este enfoque amplía la conversación sobre Embodied AI. Nos obliga a mirar más allá del hardware y considerar las implicaciones culturales, psicológicas y éticas de sistemas que afectan cómo nos vemos y cómo nos ven los demás. Porque los algoritmos movilizan ideas. Deciden qué es bello, qué es deseable, qué es profesional, qué es normal.

Esa es la mirada que aporta Oliver: la que conecta IA y sociedad, técnica y emoción, datos y derechos. Una mirada necesaria para anticipar los futuros que estamos construyendo con cada selfie, cada prompt y cada filtro.

Desde la Fundación Innovación Bankinter seguiremos impulsando esta conversación. Porque la IA, además de ser una cuestión de eficiencia o productividad, es también una cuestión de humanidad.

Directora Data Scientist en Data Pop Alliance